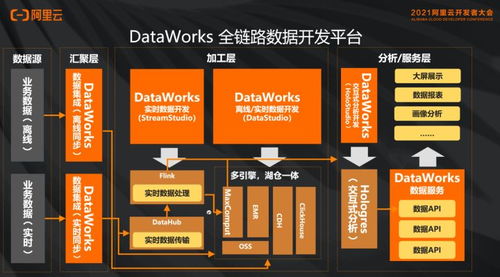

云原生数据湖构建 分析与开发治理最佳实践及案例分享

随着数字化转型的深入,企业对数据处理和存储的需求日益增长。云原生数据湖作为一种现代化数据架构,凭借其弹性、可扩展性和成本效益,成为众多企业的首选。本文将探讨云原生数据湖的构建过程,分享分析与开发治理的最佳实践,并通过实际案例说明数据处理和存储支持服务的应用。

一、云原生数据湖的概念与价值

云原生数据湖是基于云基础设施构建的数据存储和处理平台,支持结构化和非结构化数据的统一管理。其核心价值在于:

- 弹性扩展:利用云服务的自动扩缩容能力,适应数据量和计算需求的波动。

- 成本优化:按需付费模式降低初始投资,同时通过分层存储(如热、温、冷存储)优化成本。

- 开放性与集成:兼容多种数据格式和工具(如Apache Hadoop、Spark、Presto),便于企业现有系统的集成。

二、云原生数据湖构建的关键步骤

构建一个高效的云原生数据湖需遵循以下步骤:

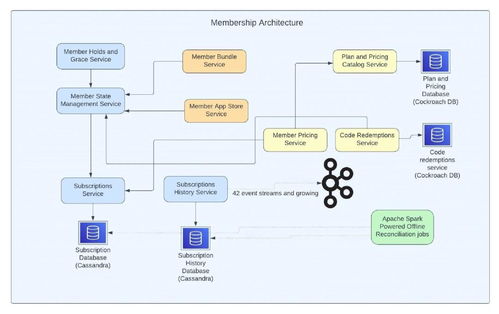

- 需求分析与架构设计:明确业务目标,设计数据分层(原始层、处理层、服务层)和安全策略。

- 选择云平台与存储服务:例如AWS S3、Azure Data Lake Storage或Google Cloud Storage,结合对象存储和文件系统。

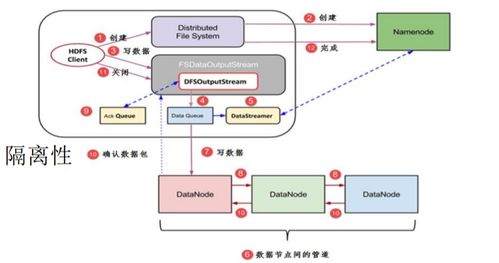

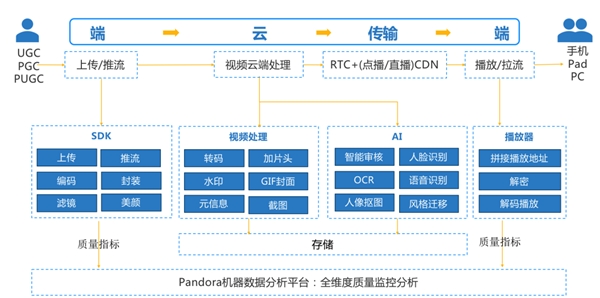

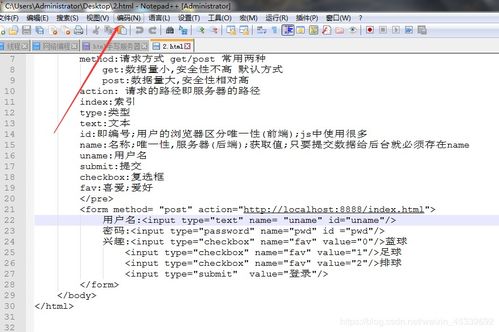

- 数据处理流水线搭建:使用工具如Apache Kafka进行数据摄取,并通过Spark或Flink进行实时或批处理。

- 元数据管理与目录化:集成Apache Hive或AWS Glue等元数据服务,实现数据发现和治理。

- 安全与合规性配置:实施加密、访问控制和审计日志,确保数据符合GDPR等法规。

三、分析与开发治理的最佳实践

在数据湖中,分析和开发治理是保证数据质量和效率的核心。最佳实践包括:

- 数据质量管理:通过数据血缘追踪和数据校验工具(如Great Expectations)监控数据准确性。

- 开发协作与版本控制:采用GitOps方法管理数据处理代码,结合CI/CD流水线实现自动化部署。

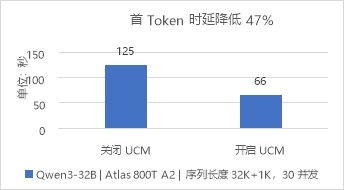

- 成本与性能优化:定期审查存储使用情况,利用压缩和分区技术减少查询延迟;通过监控工具(如Prometheus)跟踪资源利用率。

- 治理框架建立:制定数据策略,包括数据分类、保留策略和角色权限管理,使用工具如Collibra或Alation支持治理流程。

四、案例分享:数据处理和存储支持服务的实际应用

案例一:电商企业的实时分析平台

一家全球电商公司构建云原生数据湖于AWS上,使用S3作为主存储,并通过Kinesis和Lambda处理实时交易数据。他们实施了数据治理策略,确保用户行为数据的安全和合规。结果:查询性能提升50%,成本降低30%,并支持了实时推荐系统的开发。

案例二:金融行业的风险管理系统

某银行采用Azure Data Lake Storage,结合Databricks进行大数据处理。通过严格的访问控制和数据加密,他们实现了对交易数据的实时监控和分析。开发团队使用Azure DevOps管理代码,确保治理一致性。成果:风险报告生成时间从小时级缩短到分钟级,并满足了监管要求。

五、数据处理和存储支持服务的未来趋势

随着AI和机器学习的普及,云原生数据湖正演变为“数据湖屋”,结合数据仓库的强一致性优势。服务如Snowflake和Delta Lake提供了ACID事务支持,进一步简化了数据处理。企业应关注无服务器计算和边缘集成,以提升数据处理效率。

云原生数据湖的构建不仅是技术实现,更涉及治理和优化。通过遵循最佳实践和借鉴成功案例,企业可以充分发挥数据价值,驱动业务创新。如果您需要进一步指导,可咨询专业的数据服务提供商,获取定制化支持。

如若转载,请注明出处:http://www.zdchumei.com/product/40.html

更新时间:2026-02-24 03:20:48