微服务架构下的数据统一分析 报表、数据处理与存储支持服务的设计与实践

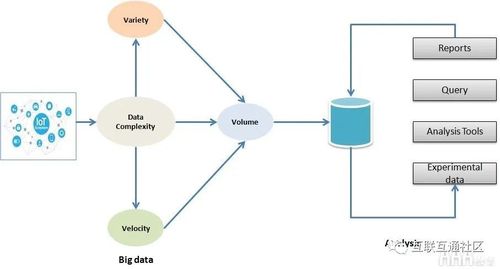

在微服务架构成为现代应用开发主流范式的今天,其带来的敏捷开发、独立部署、技术异构等优势已深入人心。当企业将单体应用拆分为众多细粒度的服务后,一个显著的挑战随之而来:如何跨越这些分散的服务边界,对数据进行统一、高效的分析,以支撑商业智能(BI)、运营报表和数据分析需求?传统的集中式数据仓库或直接数据库查询模式在微服务环境下往往捉襟见肘。本文将系统探讨微服务之后,如何处理数据的统一分析,并构建支持报表、数据处理与存储的关键服务体系。

一、 核心挑战:数据孤岛与一致性难题

微服务倡导“数据库私有化”,即每个服务拥有并管理自己的专属数据库。这虽然保障了服务的自治性与松耦合,却直接导致了数据的物理分散。当需要进行跨服务的综合分析(例如,需要结合“用户服务”、“订单服务”、“商品服务”的数据生成一份销售全景报表)时,面临以下核心挑战:

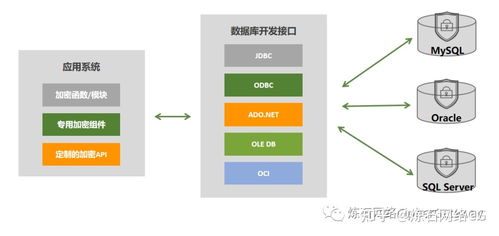

- 数据分散与聚合困难:数据分布在不同的数据库(可能是MySQL, PostgreSQL, MongoDB等异构存储)中,无法通过简单的SQL Join完成查询。

- 性能与稳定性风险:直接在生产环境的微服务数据库上运行复杂的分析查询,会消耗大量资源,可能影响在线业务的响应速度和稳定性。

- 数据一致性与时效性:微服务间通过异步消息传递实现最终一致性。分析系统可能读取到尚未完全同步的中间状态数据,导致报表数据短暂不一致。

- 数据模型差异:各服务内部的数据模型是为领域功能设计的,与分析所需的维度模型(如星型模型、雪花模型)存在巨大差异。

二、 解决方案蓝图:构建统一数据分析平台

应对上述挑战,需要构建一个独立于在线微服务集群的、专门面向分析场景的数据平台。其核心思路是:将数据从各微服务的生产数据库中“安全地”抽取出来,经过转换和整合,加载到一个专为分析优化的集中式存储中,并在此之上构建数据处理与报表服务。

1. 数据处理管道:从抽取到服务

- 数据抽取与同步:

- 变更数据捕获(CDC):这是当前最主流且对源系统侵入性最小的方式。通过解析数据库的日志(如MySQL的binlog, PostgreSQL的WAL),实时捕获数据的插入、更新、删除事件。工具如Debezium、阿里巴巴的Canal是优秀选择。

- 事件溯源与领域事件:如果微服务架构本身基于事件驱动,各服务在状态变更时发布“领域事件”(如

OrderCreated,UserProfileUpdated)。分析系统可以订阅这些事件流(通常通过Kafka、Pulsar等消息中间件),作为数据来源。这种方式与业务逻辑耦合更紧密,能获得更丰富的语义信息。

- API轮询:作为补充方案,对于不支持CDC或事件的数据源,可以通过调用微服务提供的只读API定期获取数据。

* 数据转换与集成(ETL/ELT):

捕获的原始数据需要被清洗、转换并集成为适合分析的数据模型。这一过程可以在数据管道中(ETL)或加载到数据仓库后再进行(ELT)。

- 流式处理:对于实时性要求高的场景(如实时大屏),使用Apache Flink、Spark Streaming等框架对CDC或事件流进行实时转换和聚合。

- 批处理:对于T+1的日级报表,可以使用Apache Spark、AWS Glue、或基于SQL的dbt等工具进行周期性的批量处理。

- 关键转换:包括格式标准化、关联关系建立(基于业务键)、数据去重、构建维度表和事实表等。

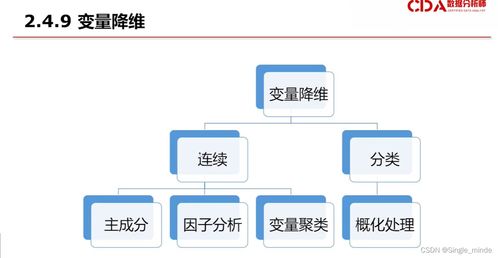

2. 分析数据存储:选型与分层

处理后的数据需要存入专门的分析型存储,其选型取决于对数据规模、查询模式和实时性的要求。

- 数据仓库:适用于结构化的、基于SQL的复杂关联查询和批处理报表。如 Snowflake、Amazon Redshift、Google BigQuery 等云原生数仓,或 Apache Hive(基于Hadoop)。它们擅长处理PB级数据,支持标准的SQL和并发查询。

- 数据湖:用于存储原始或半结构化的海量数据,格式灵活(JSON, Parquet, ORC等)。如基于 Amazon S3、Azure Data Lake Storage、HDFS 构建的数据湖。常与 Presto/Trino(用于交互式查询)、Spark(用于处理)结合使用,形成湖仓一体架构。

- OLAP数据库:针对多维分析(上卷、下钻、切片、切块)进行了极致优化。如 ClickHouse、Doris、StarRocks,它们能在亚秒级响应海量数据的聚合查询,非常适合作为实时报表和BI工具的直接后端。

一个典型的架构是分层设计:

- ODS(操作数据层):近乎实时地同步微服务的原始数据,保持与源系统一致。

- DWD/DIM(明细/维度层):对ODS数据进行清洗、整合,形成业务明细事实表和一致性维度表。

- DWS/ADS(汇总/应用层):基于DWD层进行轻度或重度汇总,形成面向特定分析主题(如销售、用户行为)的数据集市或宽表,直接供报表和BI工具使用。

3. 报表与数据服务支持

当数据准备就绪后,需要提供安全、高效的数据服务出口。

- BI与可视化工具集成:将分析存储(如数仓或OLAP库)直接连接至 Tableau、Power BI、Superset、Metabase 等BI工具。数据分析师和业务人员可以通过这些工具自主探索和创建报表。

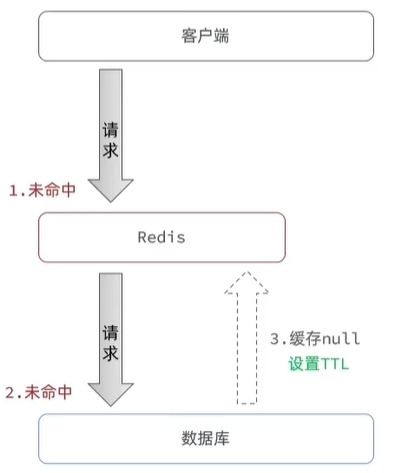

- 统一数据查询服务:构建一个统一的数据API网关或查询服务。它对外提供标准的RESTful API或GraphQL接口,封装底层复杂的数据源和查询逻辑。内部应用、运营后台或合作伙伴可以通过调用这些API获取分析数据,而无需关心数据存储在哪里。此服务应具备查询优化、缓存、限流、鉴权等能力。

- 报表即服务:对于固定的、高频的报表需求,可以开发专门的微服务——“报表服务”。该服务内部封装从分析存储中获取数据、生成特定格式(PDF, Excel)报表的逻辑,并可能包含定时调度、邮件推送等功能。

三、 关键设计原则与最佳实践

- 解耦与自治:数据分析平台应与在线业务微服务解耦,通过异步、基于日志或事件的方式获取数据,避免直接查询生产库,保障双方稳定性。

- 确保数据质量:在数据管道中建立数据质量检查点(如非空校验、唯一性校验、值域校验),并建立数据血缘追踪,以便在出现问题时能快速定位根源。

- 平衡实时性与成本:并非所有分析都需要实时数据。应根据业务重要性定义不同的数据新鲜度等级(实时、近实时、小时级、天级),并据此设计不同的数据处理链路和存储方案,以优化成本。

- 安全与权限:分析数据可能包含敏感信息。必须实施严格的权限控制,在数据同步(脱敏)、存储(加密)和访问(基于角色或属性的访问控制)各环节保障数据安全。

- 可观测性:对整个数据管道(延迟、吞吐量、错误率)、存储系统(查询性能、资源使用率)和服务(API响应时间、可用性)建立全面的监控和告警。

###

微服务架构下的数据统一分析,本质上是构建一个以数据管道为动脉、以分析型存储为核心、以数据服务为接口的独立生态系统。它并非要回到单体时代集中式数据库的老路,而是通过现代数据技术,在尊重微服务自治的前提下,实现数据的“逻辑统一”与“价值聚合”。成功的实施不仅能解决报表难题,更能为企业沉淀高质量的数据资产,赋能数据驱动的决策与创新,从而最大化微服务架构的长期价值。

如若转载,请注明出处:http://www.zdchumei.com/product/56.html

更新时间:2026-02-24 21:27:28