大数据治理所需能力与关键技术及数据处理和存储支持服务

随着大数据技术的快速发展,数据已成为企业的重要资产。有效的大数据治理是确保数据质量、安全性和价值实现的关键。大数据治理需要具备多方面的能力,并依赖于一系列关键技术,同时数据处理和存储支持服务在其中扮演着重要角色。本文将详细阐述这些内容。

一、大数据治理所需的核心能力

- 数据质量管理能力:大数据治理要求企业具备识别、监控和改善数据质量的能力。这包括数据准确性、完整性、一致性和及时性等方面的管理,以支持可信的数据分析和决策。

- 数据安全与合规能力:在大数据环境中,保护数据隐私和确保合规性至关重要。企业需要建立数据访问控制、加密机制和审计流程,以遵守相关法规如GDPR或数据安全法。

- 数据生命周期管理能力:从数据采集、存储、处理到归档和销毁,大数据治理需要全生命周期的管理能力,确保数据高效利用且成本可控。

- 元数据管理能力:通过元数据管理,企业能够理解数据的来源、结构和用途,从而提高数据可发现性和可重用性。

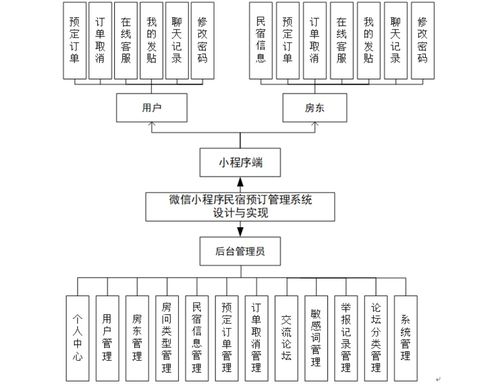

- 组织协作能力:大数据治理涉及跨部门协作,需要建立清晰的治理框架、角色职责和沟通机制,确保数据策略的一致执行。

- 战略规划能力:企业需具备制定数据治理战略的能力,将其与业务目标对齐,推动数据驱动的文化转型。

二、大数据治理的关键技术

- 数据集成与ETL技术:ETL(提取、转换、加载)工具和技术是大数据治理的基础,用于从异构数据源整合数据,确保数据一致性和可用性。例如,Apache NiFi和Talend等工具支持实时数据集成。

- 数据质量管理工具:自动化工具如Informatica Data Quality或开源方案如Apache Griffin,可帮助监控数据质量指标,自动检测和修复数据问题。

- 数据安全与隐私技术:包括数据加密(如AES算法)、匿名化技术、访问控制机制(如基于角色的访问控制RBAC),以及数据脱敏工具,确保数据在存储和传输过程中的安全。

- 元数据管理平台:工具如Apache Atlas或Collibra提供元数据采集、分类和 lineage追踪功能,帮助用户理解数据血缘和影响分析。

- 数据目录与发现工具:通过数据目录技术,企业能够建立统一的数据资产清单,提升数据的可发现性和自助服务能力。

- 人工智能与机器学习:AI技术可用于自动化数据分类、异常检测和治理决策,例如使用机器学习模型预测数据质量风险。

- 数据治理框架:如DAMA-DMBOK或DCAM,提供标准化的治理流程和最佳实践指导。

三、数据处理和存储支持服务

数据处理和存储支持服务是实施大数据治理的重要基础设施,确保数据高效、可靠地存储和处理。关键服务包括:

- 数据处理服务:

- 批处理与流处理:批处理服务(如Apache Spark)适用于大规模历史数据分析,而流处理服务(如Apache Kafka或Flink)支持实时数据处理,满足即时决策需求。

- 数据清洗与转换:云服务如AWS Glue或Azure Data Factory提供托管的数据处理服务,自动化数据清洗、转换和加载任务。

- 数据计算引擎:例如,Hadoop MapReduce或云原生服务(如Google BigQuery)提供高性能的数据计算能力,支持复杂查询和分析。

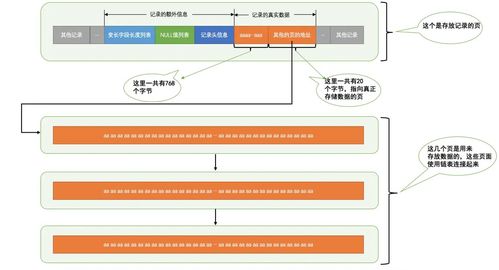

- 数据存储服务:

- 分布式存储系统:如Hadoop HDFS或云存储服务(如Amazon S3、Azure Blob Storage),提供可扩展、高可用的数据存储,支持结构化、半结构化和非结构化数据。

- 数据湖与数据仓库:数据湖(如基于AWS S3的数据湖)允许原始数据存储,而数据仓库(如Snowflake或Redshift)提供优化的查询性能,便于分析和治理。

- 备份与恢复服务:云提供商提供自动备份和灾难恢复解决方案,确保数据持久性和业务连续性。

- 数据归档服务:对于不常用数据,归档服务(如AWS Glacier)可降低存储成本,同时保持数据可访问性。

四、总结

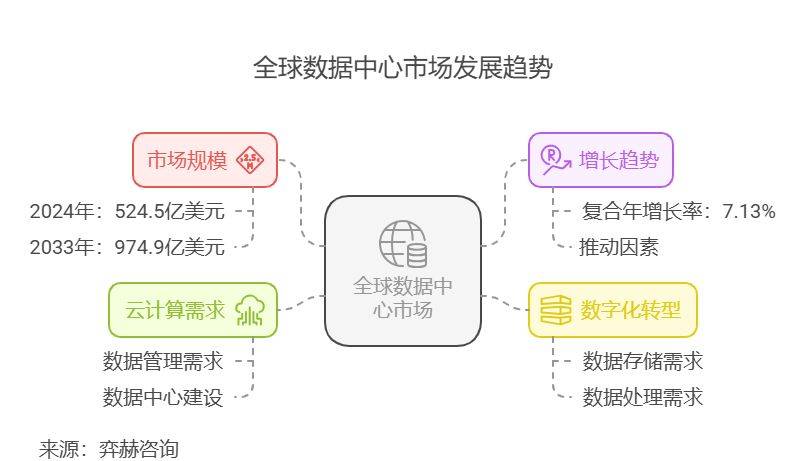

大数据治理是一个综合性的过程,需要企业具备数据质量、安全、生命周期管理等多方面能力,并利用数据集成、质量管理、安全技术和AI等关键技术。同时,强大的数据处理和存储支持服务,如批处理、流处理、分布式存储和数据湖,为治理提供可靠基础。通过整合这些能力和技术,企业能够最大化数据价值,降低风险,并推动数字化转型。在实际应用中,建议企业根据自身需求选择合适的工具和服务,并持续优化治理框架。

如若转载,请注明出处:http://www.zdchumei.com/product/13.html

更新时间:2026-02-24 01:14:50